2. 武警安徽省总队机动支队, 安徽 合肥 230041

2. Anhui Provincial Armed Police Corps Mobile Detachment, Hefei 230041, China

高光谱遥感能够同时获取地物空间维和光谱维信息,具有图谱合一的特点[1]。高光谱影像分类是高光谱影像应用的重要环节,其主要任务是为图像中的每一个像元点赋予唯一的类别标识。高光谱影像的分类任务通常需要大量的标记样本,而标记样本的获取是一项费时费力的工作。同时,高光谱影像分类中高维和小样本的特性也容易产生维数灾难问题[2]。

早期的高光谱影像分类方法侧重于探索影像的光谱特征在分类中的作用,在这些方法中,K近邻[3](KNN)分类器和支持向量机[4](SVM)因其良好的分类性能而得到了广泛的应用。此外,基于图的方法[5]、极限学习机[6]、基于稀疏表达的方法[7]也被进一步应用于高光谱影像分类。然而,这些像素级分类器没有考虑影像的空间上下文信息,得到的分类结果不尽人意。后续研究表明,综合利用高光谱影像的空间和光谱信息能有效提高分类精度,因此,拓展形态学剖面[8](EMP)、马尔可夫随机场[9](MRF)、局部二值模式[10](LBP)、Gabor滤波器[11]等方法被应用于高光谱影像的空间特征提取,进一步提高了影像的分类精度。虽然早期的分类方法在影像分类中扮演了重要的角色,但是它们在很大程度上依赖于人为设计的特征,具有很强的经验性。

在深度学习时代,基于卷积神经网络的方法能够通过一系列的层次结构从原始影像数据中自动提取抽象的特征,避免了复杂的人为特征设计,因此取得了广泛应用。目前大多数基于卷积神经网络的高光谱影像分类方法大致可以分为光谱特征提取网络、空间特征提取网络和空谱特征提取网络[12]。光谱特征提取网络旨在通过堆叠的层次结构提取影像的深层光谱特征。经典的光谱特征提取网络有堆栈式自编码器[13](SAE)、深度置信网络[14](DBN)、一维卷积神经网络[15](1D-CNN)、一维生成对抗网络[16]和循环神经网络[17](RNN)。此外,文献[18]利用卷积神经网络探索了高光谱影像像素对的光谱特征。文献[19]利用字典学习来训练卷积神经网络,取得了更好的分类效果。与光谱特征网络不同,空间特征提取网络利用深度网络提取影像的空间信息,并将学习到的空间特征与其他特征提取技术提取的光谱特征进行融合,以获得更高的分类精度。文献[20]将主成分分析(PCA)和二维卷积神经网络(2D-CNN)相结合,提取了影像的空间和光谱信息。文献[21]提出了一种多尺度的空间特征提取网络,并使用权重机制融合了不同尺度的空间结构信息和光谱信息,取得了更佳的分类效果。空谱特征提取网络能够同时提取影像的空谱联合信息。其中,三维卷积神经网络[22](3D-CNN)利用三维卷积层对高光谱影像立方体进行端到端的空谱特征提取,取得了较好的分类结果。文献[23]利用残差学习模块构建了深层三维卷积网络(Res-3D-CNN),有效地解决了三维卷积网络的深层退化问题。上述基于卷积神经网络的方法虽然取得了一定进展,但是它们只对影像的规则格网区域进行卷积,在特征提取过程中无法很好地表达影像的不规则局部区域,导致在训练样本较少的情况下出现误分类。

近年来,图神经网络(GNN)引起了越来越多的关注。文献[24]在不动点理论的基础上首次提出了GNN模型,它可以聚合图的节点特征,并将整个图嵌入到新的特征空间中。文献[25]在频谱图理论的基础上提出了卷积神经网络的表述。在频谱图理论的基础上,文献[26]提出了GCN模型,该模型基于非欧几里得数据进行运算,通过隐含层的学习,可以聚合图中每个图节点的邻居特征信息,进而对节点特征和局部图结构进行编码。若将高光谱影像中的每个像素视作一个图节点,则可以将高光谱影像转换为图结构数据,进而利用GCN对影像中的不规则局部区域进行表达,以提高影像在小样本情况下的分类精度。

本文设计了一种基于图卷积网络的高光谱影像分类方法(rotation-invariant uniform local binary pattern and graph convolutional neural network,RULBP+GCN),该方法在纹理特征提取的基础上,通过K近邻方法将影像构建为拓扑图结构,并输入图卷积网络模型进行影像分类,以提高影像在小样本情况下的分类精度。

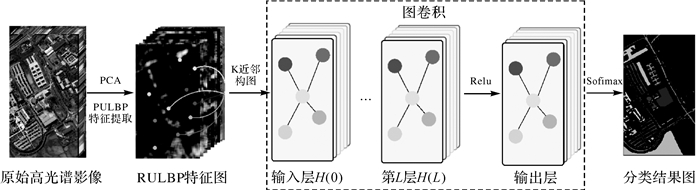

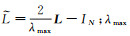

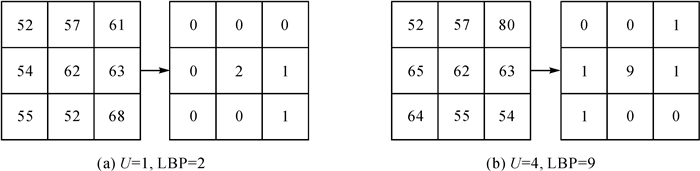

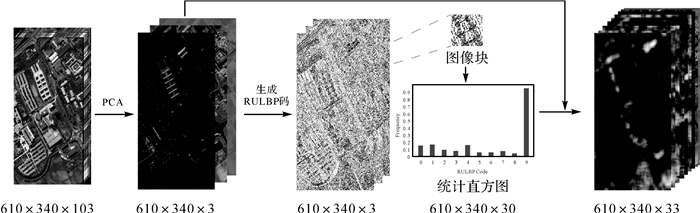

1 本文方法本文方法的总体流程如图 1所示,该方法主要由3部分组成:LBP纹理特征提取,K近邻构图和图卷积网络分类。对于原始高光谱影像,首先,通过主成分分析(PCA)将影像降维至3个波段;然后,提取3个波段的LBP纹理特征,并利用K近邻方法对影像进行构图;最后,使用图卷积网络提取图节点的特征,并利用softmax函数生成每个节点的预测标签,进而得到影像的分类结果图。

|

| 图 1 基于图卷积网络的高光谱影像分类方法流程 Fig. 1 Flow chart of hyperspectral image classification method based on graph convolution network |

文献[10]指出,结合高光谱影像的LBP纹理特征和光谱特征能够显著提升影像在小样本情况下的分类精度。本文方法利用局部二值模式(LBP)提取影像的局部空间特征,并将提取得到的空间特征与影像的光谱特征相结合,综合利用影像的空间信息和光谱信息。另外,在特征提取的基础上,使用K近邻方法将影像构图,充分建立影像不同样本点之间的全局关联。随后,基于样本点之间的关联关系,利用图卷积网络聚合不同样本点的特征,以充分利用影像的样本信息,提高影像在小样本条件下的分类精度。下文将分别介绍图卷积网络、K近邻构图和局部二值模式。

1.1 图卷积网络图卷积网络是一种可以直接对图结构数据进行操作的特征提取器,它可以通过图卷积操作,充分利用节点之间的依赖关系和每个邻居节点的特征信息。因此,与基于卷积神经网络的深度学习模型不同,GCN可以直接应用于不规则数据。

图是一种非欧几里得数据结构,可以定义为G=(V, E),其中V和E分别是高光谱影像构图后对应的节点集和边集。图G对应的邻接矩阵记为A∈RN×N,记录影像各像素点之间的邻接关系。度矩阵记为Dii=

(1)

(1)

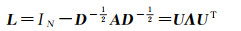

式中,U是归一化图拉普拉斯矩阵的特征向量组成的矩阵;UTx是x的图傅里叶变换。图拉普拉斯矩阵的计算公式为

(2)

(2)

式中,L为图拉普拉斯矩阵;Λ是L的特征值组成的对角矩阵。考虑到高光谱影像构图时像素节点较多,为便于在大图中计算L的特征值分解,使用切比雪夫多项式Tk(x)直到第K阶的截断展开来近似式(2),得到的计算公式为

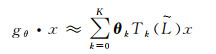

(3)

(3)

式中,

(4)

(4)

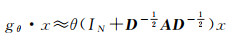

随后引入“再归一化”,即

式中,Ã=A+IN,

(5)

(5)

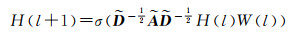

式中,H(0)=X为原始高光谱影像构图后的数据;H(l)是第l+1层的输入;W(l)是第l+1层的权值矩阵;σ代表激活函数。GCN的损失函数为

(6)

(6)

式中,yL是标记像素点的索引集合;F是输出层的特征图个数,在本文中对应高光谱影像的地物类别数量;Ylf和Zlf分别是真实标签的索引矩阵和预测标签的索引矩阵。在训练过程中,通过反向传播算法对GCN模型的所有参数进行优化,使得损失函数L最小。

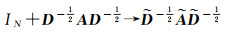

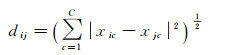

1.2 K近邻构图由于图卷积网络只能直接作用于图结构数据,因此需要将高光谱影像构建为拓扑图结构。这里将影像的每一个像素视作图的节点,通过K近邻方法构建拓扑图。高光谱影像视为特征矩阵X∈RN×C,其中N为像素个数,C为特征向量的维数。两个样本xi与j之间的欧氏距离dij的计算公式为

(7)

(7)

所有样本对的距离度量可以构成对称距离矩阵D=dij∈RN×N。例如,矩阵D中的dij表示第i个像素到第j个像素的欧氏距离。为了方便构图,这里选择距离像素xi最近的K个像素作为像素xi的邻居节点,并将它们用边连接起来,最终将高光谱影像构造成一个无向图。

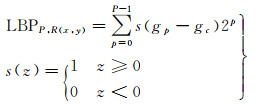

1.3 局部二值模式为进一步提高影像的分类精度,通过LBP的方法提取影像的纹理特征,并结合光谱特征进行分类。LBP是一种用来描述图像局部纹理特征的算子,具有原理简单、计算复杂度低、旋转不变性和灰度不变性等优势[27]。对于一个给定的中心像素(x, y),其LBP码的计算公式为

(8)

(8)

式中,R表示中心像素的邻域半径;P表示邻域内采样的像素点个数;LBP特征提取的(P, R)一般取值为(8,1);gc表示中心像素(x, y)的灰度值;g0, g1, …, gP-1表示邻域内像素的灰度值。由式(8)可知,中心像素的LBP码共有2P种,这将会增加特征提取过程中的空间复杂度和时间复杂度,因此考虑采用基于旋转不变性的等价LBP(rotation-invariant uniform local binary pattern,RULBP),该方法计算出的RULBP码取决于二进制中0和1的跳变次数,中心像素RULBP码的具体计算公式为

(9)

(9)

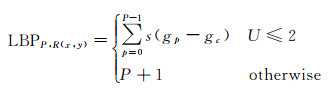

式中,U表示二进制编码中从0到1或从1到0的跳变次数。图 2给出了(P, R)取(8,1)时中心像素RULBP码的两种计算示例,在图 2(a)中,二进制数00011000对应的U值为1,因此中心像素的RULBP码为2,在图 2(b)中,二进制00110011对应的U值为4,因此中心像素的RULBP码为9。由式(9)可知,当以中心像素的8邻域为窗口计算其RULBP码时,中心像素的LBP码由原来的256种减少为10种,因此采用RULBP能够有效地减少LBP码的种类,提高了LBP特征提取的稳定性。

|

| 图 2 8邻域窗口内中心像素的LBP码计算示例 Fig. 2 Example of LBP code calculation of center pixel in eight-neighborhood window |

对于高光谱影像数据,可以将影响的每个波段视为灰度图像,直接应用RULBP模型获取各波段中每个像素的RULBP码,并采用中心像素图像块的统计直方图作为该像素的RULBP特征。值得注意的是,统计直方图的横轴代表RULBP码的种类,其范围为[0, 9],纵轴代表图像块内各RULBP码出现的频率。图 3以Pavia大学数据集为例,给出了高光谱影像RULBP特征提取的具体流程,由于高光谱影像具有高维特性,且相邻波段具有高度相关性,因此首先使用主成分分析将高光谱影像降维至3个波段,然后分别对3个主成分进行RULBP特征提取,最终结合3个主成分特征与3个RULBP特征,为影像的每一个像素生成33维的特征向量。最终提取的特征包含了主要的光谱特征及RULBP提取的局部纹理特征,同时利用了高光谱影像的空间信息和光谱信息。

|

| 图 3 高光谱影像RULBP特征提取流程(以Pavia大学数据集为例) Fig. 3 Flow chart of RULBP feature extraction from hyperspectral images (taking the University of Pavia dataset as an example) |

2 试验结果及分析

试验的硬件环境为16 GB内存,IntelCorei7-9750H处理器,RTX 2070显卡。本文设计的图卷积网络基于python语言和深度学习库Tensorflow-GPU开发实现。在网络的训练过程中,设置网络的迭代次数为2000次,每隔10次记录测试样本集上模型的分类准确率,并以10次为周期对学习率实施动态衰减,在训练过程中,使用Adam函数对模型的训练损失进行优化。

2.1 试验数据为验证图卷积网络在高光谱影像分类方面的优势,选取3个常用的高光谱数据集进行分类试验,分别为Pavia大学数据集、Indian Pines数据集和Salinas数据集。

(1) Pavia大学数据集。Pavia大学数据集是由德国的机载反射光学光谱成像仪(reflective optics spectrographic imaging system,ROSIS-03)在2003年对意大利的帕维亚城成像的一部分高光谱数据,光谱覆盖范围为430~860 nm,影像大小为610×340像素,其中包含地物的像素有42 776个,空间分辨率为1.3 m,去除受噪声影响的波段后,剩余103个波段可用于分类。该数据集对9种地物进行了标注。地物类别、选取的训练样本数量、测试样本数量见表 1。

| 序号 | 地物类别 | 训练集 | 测试集 |

| 1 | asphalt | 5/10/15/20/25 | 6631 |

| 2 | meadows | 5/10/15/20/25 | 18 649 |

| 3 | gravel | 5/10/15/20/25 | 2099 |

| 4 | trees | 5/10/15/20/25 | 3064 |

| 5 | painted metal sheets | 5/10/15/20/25 | 1345 |

| 6 | bare soil | 5/10/15/20/25 | 5029 |

| 7 | bitumen | 5/10/15/20/25 | 1330 |

| 8 | self-blocking bricks | 5/10/15/20/25 | 3682 |

| 9 | shadows | 5/10/15/20/25 | 947 |

| 总计 | 45/90/135/180/225 | 42 776 | |

(2) Indian Pines数据集。Indian Pines数据集是由机载可视红外光谱仪(airborne visible infrared imaging spectrometer,AVIRIS)传感器于1992年对美国印第安纳州一块印度松树区域进行成像获得,光谱覆盖范围为400~2500 nm,影像大小为145×145像素,其中包含地物的像素有10 249个,空间分辨率为20 m,去除受噪声影响的波段后,剩余200个波段可用于分类。该数据集对16种地物进行了标注。地物类别、选取的训练样本数量、测试样本数量见表 2。值得注意的是,第9类地物仅包含20个像素,因此在每类地物选取的训练样本数目超过20时,第9类地物仍选取20个样本。

| 序号 | 类别 | 训练集 | 测试集 |

| 1 | alfalfa | 5/10/15/20/25 | 46 |

| 2 | corn-notill | 5/10/15/20/25 | 1428 |

| 3 | corn-mintill | 5/10/15/20/25 | 830 |

| 4 | corn | 5/10/15/20/25 | 237 |

| 5 | grass-pasture | 5/10/15/20/25 | 483 |

| 6 | grass-trees | 5/10/15/20/25 | 730 |

| 7 | grass-pasture-mowed | 5/10/15/20/25 | 28 |

| 8 | hay-windrowed | 5/10/15/20/20 | 478 |

| 9 | oats | 5/10/15/20/25 | 20 |

| 10 | soybean-notill | 5/10/15/20/25 | 972 |

| 11 | soybean-mintill | 5/10/15/20/25 | 2455 |

| 12 | soybean-clean | 5/10/15/20/25 | 593 |

| 13 | wheat | 5/10/15/20/25 | 205 |

| 14 | woods | 5/10/15/20/25 | 1265 |

| 15 | buildings-grass-trees-drives | 5/10/15/20/25 | 386 |

| 16 | stone-steel-towers | 5/10/15/20/25 | 93 |

| 总计 | 80/160/240/320/395 | 10 249 | |

(3) Salinas数据集。Salinas数据集是AVIRIS光谱仪获取的美国加利福尼亚州萨利纳斯山谷区域的高光谱影像,影像大小为512×217像素,其中包含地物的像素有54 129个,空间分辨率为3.7 m,原始影像共有224个波段,去除受噪声影响的波段后,剩余204个波段可用于分类。该数据集对16种地物进行了标注。地物类别、选取的训练样本数量、测试样本数量见表 3。

| 序号 | 类别 | 训练集 | 测试集 |

| 1 | brocoli_green_weeds_1 | 5/10/15/20/25 | 2009 |

| 2 | brocoli_green_weeds_2 | 5/10/15/20/25 | 3726 |

| 3 | fallow | 5/10/15/20/25 | 1976 |

| 4 | fallow_rough_plow | 5/10/15/20/25 | 1394 |

| 5 | fallow_smooth | 5/10/15/20/25 | 2678 |

| 6 | stubble | 5/10/15/20/25 | 3959 |

| 7 | celery | 5/10/15/20/25 | 3579 |

| 8 | grapes_untrained | 5/10/15/20/25 | 11 271 |

| 9 | soil_vinyard_develop | 5/10/15/20/25 | 6203 |

| 10 | corn_senesced_green_weeds | 5/10/15/20/25 | 3278 |

| 11 | lettuce_romaine_4wk | 5/10/15/20/25 | 1068 |

| 12 | lettuce_romaine_5wk | 5/10/15/20/25 | 1927 |

| 13 | lettuce_romaine_6wk | 5/10/15/20/25 | 916 |

| 14 | lettuce_romaine_7wk | 5/10/15/20/25 | 1070 |

| 15 | vinyard_untrained | 5/10/15/20/25 | 7268 |

| 16 | vinyard_vertical_trellis | 5/10/15/20/25 | 1807 |

| 总计 | 80/160/240/320/400 | 54 129 | |

2.2 试验参数设置

在GCN正式训练之前,首先需要确定最佳试验参数。试验中需要确定的参数包括每个节点的邻居节点数量K,GCN模型的网络结构以及学习率。

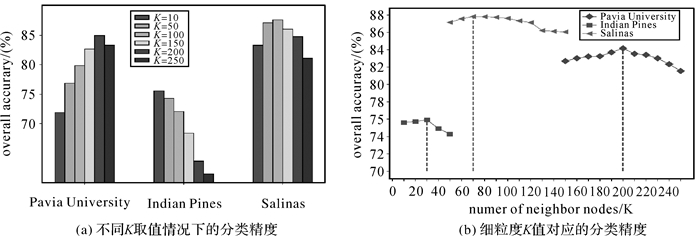

在K近邻构图的过程中,参数K的含义是图中每个节点的邻居数量,在试验过程中,如果K太小, 则无法充分表达节点之间的依赖关系,不利于分类精度的提高;如果K取值过大,则节点会聚合邻居节点中不利于分类的信息,进而降低分类精度。图 4(a)给出了不同K取值情况下3个数据集的分类精度,由图 4(a)可知,随着K的增加,分类精度呈现先上升后下降的趋势。为确定参数K的最佳值,在最高分类精度对应的参数附近进行K值的细粒度查找,如图 4(b)所示。在图 4(b)中,Pavia大学在K值为200时分类精度最高,Indian Pines在K值为30时分类精度最高,Salinas在K值为70时分类精度最高。因此最终在K近邻构图的过程中,Pavia大学、Indian Pines和Salinas的K值分别取为200、30和13。

|

| 图 4 不同邻居节点对应的分类精度(%) Fig. 4 Classification accuracy corresponding to different neighbor nodes (%) |

与卷积神经网络类似,GCN的网络结构会影响到网络的学习能力,最终影响影像的分类精度和分类效率。表 4给出了不同网络结构对应的影像总体分类精度和训练时间,本文使用不同的节点组合来表示GCN不同的网络结构,例如,8表示包含8个节点的单个隐藏层;8-16表示分别包含8个节点和16个节点的两个隐藏层;8-16-32表示分别包含8个节点、16个节点和32个节点的3个隐藏层。表 4中加粗的数据为最高的分类精度或最少的训练时间。由表 4可知,对于3组高光谱数据集,不同网络结构对应的训练时间差别不大,因此最终选取总体分类精度较高的节点组合作为最终的网络结构,Pavia大学数据集对应的网络结构为包含32个节点的单个隐藏层,Indian Pines数据集和Salinas数据集对应的网络结构为包含64个节点的单个隐藏层。

| 网络结构 | Pavia大学 | Indian Pines | Salinas | |||||

| 分类精度/(%) | 训练时间/s | 分类精度/(%) | 训练时间/s | 分类精度/(%) | 训练时间/s | |||

| 8 | 81.90 | 203.31 | 62.68 | 22.48 | 79.09 | 103.21 | ||

| 16 | 83.47 | 242.30 | 67.76 | 34.46 | 78.41 | 110.75 | ||

| 32 | 83.89 | 257.38 | 71.71 | 36.08 | 84.17 | 123.57 | ||

| 64 | 79.36 | 263.66 | 72.65 | 37.96 | 86.86 | 144.57 | ||

| 128 | 80.90 | 293.36 | 71.30 | 26.40 | 86.24 | 156.70 | ||

| 8-16 | 83.75 | 212.02 | 69.20 | 30.69 | 78.32 | 140.43 | ||

| 16-32 | 80.16 | 284.86 | 71.00 | 49.38 | 79.98 | 189.71 | ||

| 32-64 | 79.78 | 315.95 | 68.74 | 23.29 | 83.76 | 152.38 | ||

| 64-128 | 77.74 | 341.42 | 71.84 | 27.44 | 84.29 | 171.17 | ||

| 8-16-32 | 77.15 | 309.01 | 67.53 | 54.30 | 79.88 | 168.20 | ||

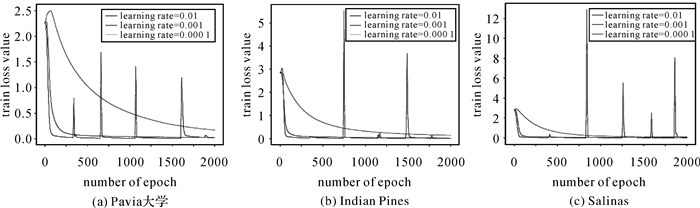

参照深度学习应用于高光谱影像分类试验的一般经验,将学习率分别设置为0.1、0.01、0.001和0.000 1,图 5展现了不同学习率对应的损失函数值。由图 5可知,较大的学习率(如0.01)将会导致损失函数值波动较大,不利于模型的训练;较小的学习率(如0.001)将产生较低的损失函数值,使得模型的拟合能力更强。因此3个试验数据集的学习率均设置为0.001。

|

| 图 5 不同学习率对应的损失函数曲线 Fig. 5 The loss function curve corresponding to different learning rates |

2.3 试验结果与分析

为验证本文提出的方法(RULBP+GCN)应对小样本问题的有效性,每类地物分别随机选取5、10、15、20、25个训练样本进行分类,并将本文方法与支持向量机(SVM)[28]、直推式支持向量机(transductive support vector machine,TSVM)[29]、一维卷积神经网络(1DCNN)[15]、二维卷积神经网络(2DCNN)[20]、三维卷积神经网络(3DCNN)[22]、半监督生成对抗网络(SGAN)[30]以及深度少样例学习方法(DFSL+SVM)[31]进行对比分析。其中,SVM是一种常用的监督分类器,其核函数采用高斯径向基函数;TSVM是一种半监督分类方法,其核心思想是尝试为未标记样本找到合适的标签值,使得超平面划分后的间隔最大化;1DCNN、2DCNN和3DCNN是常用的深度学习方法;SGAN是一种半监督的深度学习方法;DFSL+SVM在训练深度三维卷积神经网络的过程中模拟小样本分类的情况,并将提取到的特征输入支持向量机中进行分类,能有效解决小样本分类问题。值得注意的是,上述对比方法均以原始高光谱影像作为输入,未进行PCA降维和RULBP特征提取,因此为了保证对比试验的公平性,设置一组未进行PCA降维与RULBP特征提取的图卷积网络分类试验,记作GCN。表 5至表 7分别给出了RULBP+GCN和不同对比方法在3组高光谱影像数据集上的总体分类精度。表中数据为10次试验结果的总体分类精度的均值和标准差。

| 方法 | L=5 | L=10 | L=15 | L=20 | L=25 |

| SVM | 60.77±1.30 | 64.72±1.14 | 66.74±0.94 | 67.92±1.14 | 70.37±2.62 |

| TSVM | 63.98±1.22 | 75.79±0.45 | 78.95±1.07 | 81.31±0.27 | 84.10±1.39 |

| 1DCNN | 59.83±5.17 | 63.67±2.07 | 68.6±1.56 | 69.73±0.46 | 71.21±0.49 |

| 2DCNN | 65.15±5.08 | 71.62±2.09 | 79.24±1.05 | 80.11±2.13 | 85.43±1.68 |

| 3DCNN | 67.85±5.37 | 74.75±1.99 | 80.40±1.01 | 83.33±1.43 | 86.25±1.47 |

| SGAN | 63.91±4.41 | 69.05±2.73 | 72.27±1.75 | 74.05±1.58 | 76.31±1.71 |

| DFSL+SVM | 72.57±3.93 | 84.56±1.83 | 87.23±1.38 | 90.69±1.29 | 93.08±0.92 |

| GCN | 68.77±3.73 | 72.36±1.76 | 74.23±1.51 | 77.85±1.35 | 80.82±1.08 |

| RULBP+GCN | 85.74±3.21 | 89.71±1.54 | 93.10±1.48 | 94.43±1.27 | 95.43±0.79 |

| 方法 | L=5 | L=10 | L=15 | L=20 | L=25 |

| SVM | 37.56±1.74 | 43.29±2.04 | 49.60±0.80 | 51.60±0.64 | 56.41±0.63 |

| TSVM | 44.99±0.23 | 54.66±0.17 | 58.22±0.02 | 64.43±0.20 | 66.65±1.67 |

| 1DCNN | 42.81±3.23 | 48.12±2.14 | 53.29±2.02 | 57.95±0.98 | 59.08±1.94 |

| 2DCNN | 47.34±2.86 | 54.75±2.08 | 61.6±1.86 | 66.48±0.86 | 67.31±1.61 |

| 3DCNN | 48.8±2.17 | 55.77±1.34 | 63.02±1.74 | 68.03±0.67 | 76.23±1.38 |

| SGAN | 49.13±3.41 | 59.81±1.96 | 66.6±1.53 | 67.85±1.02 | 72.04±1.82 |

| DFSL+SVM | 64.58±2.78 | 75.53±1.89 | 79.98±2.23 | 83.01±1.67 | 85.47±1.21 |

| GCN | 49.31±2.18 | 56.53±1.08 | 60.03±1.59 | 63.19±1.64 | 64.71±1.36 |

| RULBP+GCN | 77.70±2.48 | 85.89±1.47 | 86.62±1.39 | 89.32±1.42 | 90.29±1.05 |

| 方法 | L=5 | L=10 | L=15 | L=20 | L=25 |

| SVM | 65.54±1.91 | 71.46±1.73 | 77.74±1.45 | 78.48±1.20 | 79.91±1.49 |

| TSVM | 78.01±1.40 | 83.60±1.05 | 84.42±1.32 | 85.58±1.78 | 85.88±1.16 |

| 1DCNN | 77.51±2.08 | 80.86±1.93 | 82.95±1.73 | 83.35±1.25 | 85.17±1.27 |

| 2DCNN | 79.42±1.94 | 85.24±1.15 | 86.74±1.68 | 87.84±1.25 | 88.71±1.05 |

| 3DCNN | 81.71±1.86 | 87.05±1.08 | 88.31±1.49 | 89.21±1.25 | 91.37±0.92 |

| SGAN | 75.94±1.93 | 81.49±1.51 | 84.72±1.17 | 87.62±1.25 | 91.50±1.41 |

| DFSL+SVM | 85.58±1.87 | 89.73±1.24 | 91.21±1.64 | 93.42±1.25 | 94.28±0.80 |

| GCN | 82.62±1.09 | 87.38±1.18 | 87.49±1.08 | 87.86±0.96 | 89.04±1.34 |

| RULBP+GCN | 86.71±0.97 | 91.63±1.05 | 91.54±0.88 | 93.51±0.84 | 94.44±0.92 |

观察并分析表 5-表 7中的试验结果可知,所有方法的总体分类精度随着每类地物训练样本数量L的增加而提升,表明增加监督样本的数量和引入未标记样本可以提高高光谱影像的分类精度。由于半监督方法能够有效利用未标记样本,一定程度上缓解了标记样本不足的问题,因此半监督支持向量机TSVM的分类精度高于传统支持向量机SVM的分类精度。1DCNN、2DCNN、3DCNN、SGAN、DFSL+SVM、GCN以及RULBP+GCN等深度学习方法的分类精度总体上均高于传统的支持向量机方法,表明深度学习方法具备更强的特征提取能力。

将GCN与其他深度学习方法(1DCNN、2DCNN、3DCNN、SGAN、DFSL+SVM)的分类精度进行对比分析可知,在每类地物随机选取5个训练样本的情况下,GCN的分类精度高于1DCNN、2DCNN、3DCNN和SGAN,但明显低于DSFL+SVM。这表明即使不进行影像的PCA降维和纹理特征提取,GCN取得的分类精度仍高于卷积神经网络取得的分类精度。由于DFSL+SVM在训练过程中模拟了高光谱影像的少样例学习问题,因此在每类地物随机选取5个训练样本的条件下,能够取得更高的分类精度。但是,随着训练样本数量的增加,GCN的分类精度会出现低于2DCNN、3DCNN、SGAN和DFSL+SVM的情况,这主要是因为GCN仅仅捕捉了影像像素点之间的全局关联,忽略了影像中存在的空间信息和光谱信息,而2DCNN、3DCNN、SGAN和DFSL+SVM等方法以影像像素的邻域块作为网络的输入,一定程度上联合利用了影像的空间信息和光谱信息。

相比而言,本文提出的方法(RULBP+GCN)的总体分类精度最高,表明了RULBP+GCN在小样本情况下分类的有效性。该方法首先提取影像的局部纹理特征,并通过K近邻方法将影像构图,建立像素点之间的全局关联,其中的每个节点都包含了丰富的空间信息和光谱信息。在此基础上,GCN充分利用了节点之间的依赖关系,通过聚合邻居节点的特征信息,对高光谱影像中的局部区域进行了充分表达,进而提高了影像在小样本情况下的分类精度。另外,在3组高光谱数据集上,RULBP+GCN的总体分类精度均高于GCN的分类精度。表明了使用RULBP进行纹理特征提取的有效性。

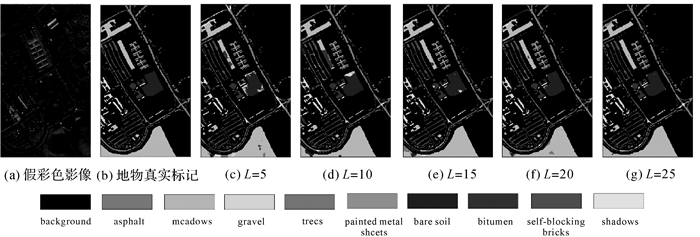

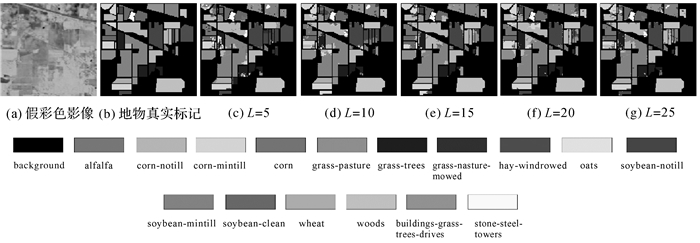

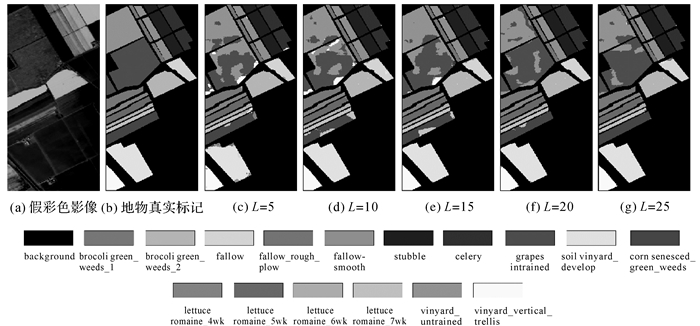

为了更加直观地观察RULBP+GCN方法的分类效果,图 6、图 7、图 8分别给出了3组数据集的假彩色影像(第10、50、100波段合成),地物真实标记,以及选取不同数量训练样本的情况下,RULBP+GCN取得的分类结果图。观察图 6、图 7、图 8可知,随着每类地物选取的训练样本数量L的增加,分类图的分类噪声逐渐减少,这也更加直观地反映了RULBP+GCN在小样本情况下的有效性。

|

| 图 6 Pavia大学数据集上选取不同数量的训练样本获得的分类结果 Fig. 6 qThe classification results obtained by selecting different number of training samples from Pavia University dataset |

|

| 图 7 Indian Pines数据集上选取不同数量的训练样本获得的分类结果 Fig. 7 The classification results obtained by selecting different number of training samples from Indian Pines dataset |

|

| 图 8 Salinas数据集上选取不同数量的训练样本获得的分类结果 Fig. 8 The classification results obtained by selecting different number of training samples from Salinas dataset |

2.4 效率对比分析

为进一步研究RULBP+GCN的计算效率,本文选择SVM、TSVM、1DCNN、2DCNN、3DCNN、SGAN和DFSL+SVM进行对比分析,见表 8,其中深度学习方法1DCNN、2DCNN、3DCNN、SGAN和DFSL+SVM的迭代次数均为2000次,每种方法的执行时间包括训练时间和测试时间。监督分类器SVM具有较少的超参数,因此执行时间很短[32-33],但其在3个数据集上的分类精度均低于RULBP+GCN。RULBP+GCN的训练时间比TSVM、1DCNN、2DCNN、3DCNN、DFSL+SVM的训练时间少,且分类精度均高于所有的对比方法,表明RULBP+GCN在保证分类精度的同时,也具备更快的执行速度。

| 执行时间 | Pavia大学 | Indian Pines | Salinas | |||||

| 训练时间 | 测试时间 | 训练时间 | 测试时间 | 训练时间 | 测试时间 | |||

| SVM | 0.02 | 0.02 | 0.26 | 0.01 | 0.18 | 0.07 | ||

| TSVM | 781.22 | 22.73 | 154.6 | 9.07 | 726.46 | 27.94 | ||

| 1DCNN | 495.76 | 0.08 | 67.66 | 0.04 | 654.39 | 0.16 | ||

| 2DCNN | 589.86 | 0.08 | 344.70 | 0.03 | 859.94 | 0.09 | ||

| 3DCNN | 1 057.18 | 22.84 | 800.14 | 4.02 | 1 400.78 | 17.36 | ||

| SGAN | 57.42 | 3.98 | 51.06 | 0.66 | 51.38 | 2.62 | ||

| DFSL+SVM | 6 372.24 | 40.82 | 6 372.24 | 27.31 | 6 372.24 | 77.74 | ||

| RULBP+GCN | 459.70 | 1.01 | 36.47 | 0.76 | 289.13 | 1.01 | ||

3 结论

为改善高光谱影像在小样本情况下的分类精度,本文提出了一种基于图卷积网络的高光谱影像分类方法。该方法首先从高光谱影像中提取RULBP特征并将其组织成图结构,随后使用GCN模型对图数据进行分类。采用Pavia大学、Indian Pines和Salinas 3组高光谱影像数据进行试验验证,试验结果表明:RULBP纹理特征提取能够有效地利用影像空间特征,有利于提高影像的分类精度;GCN模型充分利用了像素节点之间的依赖关系,通过聚合邻居节点的特征信息,有效改善了高光谱影像在小样本条件下的分类精度。

虽然本文提出的方法在小样本条件下取得了一定的成效,但影像的构图方法直接决定了各像素点之间的邻接关系,进而决定图卷积模型从邻居节点中聚合到的特征信息的优劣,最终影响影像的分类精度。进一步的研究工作将结合更加有效的影像构图方法和图卷积模型,以期在每类地物选取5个样本的条件下,获得更高的分类精度。

| [1] |

余旭初, 冯伍法, 杨国鹏, 等. 高光谱影像分析与应用[M]. 北京: 科学出版社, 2013: 3-5. YU Xuchu, FENG Wufa, YANG Guopeng, et al. Hyperspectral image analysis and application[M]. Beijing: Science Press, 2013: 3-5. |

| [2] |

BIOUCAS-DIAS J M, PLAZA A, CAMPS-VALLS G, et al. Hyperspectral remote sensing data analysis and future challenges[J]. IEEE Geoscience and Remote Sensing Magazine, 2013, 1(2): 6-36. DOI:10.1109/MGRS.2013.2244672 |

| [3] |

MA Li, CRAWFORD M M, TIAN Jinwen. Local manifold learning-based k nearest-neighbor for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2010, 48(11): 4099-4109. |

| [4] |

CAMPS-VALLS G, BRUZZONE L. Kernel-based methods for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2005, 43(6): 1351-1362. DOI:10.1109/TGRS.2005.846154 |

| [5] |

SHI Lei, ZHANG Lefei, YANG Jie, et al. Supervised graph embedding for polarimetric SAR image classification[J]. IEEE Geoscience and Remote Sensing Letters, 2013, 10(2): 216-220. DOI:10.1109/LGRS.2012.2198612 |

| [6] |

LI Wei, CHEN Chen, SU Hongjun, et al. Local binary patterns and extreme learning machine for hyperspectral imagery classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(7): 3681-3693. DOI:10.1109/TGRS.2014.2381602 |

| [7] |

CHEN Yi, NASRABADI N M, TRAN T D. Hyperspectral image classification using dictionary-based sparse representation[J]. IEEE Transactions on Geoscience and Remote Sensing, 2011, 49(10): 3973-3985. DOI:10.1109/TGRS.2011.2129595 |

| [8] |

BENEDIKTSSON J A, PALMASON J A, SVEINSSON J R. Classification of hyperspectral data from urban areas based on extended morphological profiles[J]. IEEE Transactions on Geoscience and Remote Sensing, 2005, 43(3): 480-491. DOI:10.1109/TGRS.2004.842478 |

| [9] |

TARABALKA Y, FAUVEL M, CHANUSSOT J, et al. SVM-and MRF-based method for accurate classification of hyperspectral images[J]. IEEE Geoscience and Remote Sensing Letters, 2010, 7(4): 736-740. DOI:10.1109/LGRS.2010.2047711 |

| [10] |

LI Wei, CHEN Chen, SU Hongjun, et al. Local binary patterns and extreme learning machine for hyperspectral imagery classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(7): 3681-3693. DOI:10.1109/TGRS.2014.2381602 |

| [11] |

JIA Sen, HU Jie, XIE Yao, et al. Gabor cube selection based multitask joint sparse representation for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(6): 3174-3187. DOI:10.1109/TGRS.2015.2513082 |

| [12] |

LI Shutao, SONG Weiwei, FANG Leyuan, et al. Deep learning for hyperspectral image classification: an overview[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(9): 6690-6709. DOI:10.1109/TGRS.2019.2907932 |

| [13] |

CHEN Yushi, LIN Zhouhan, ZHAO Xing, et al. Deep learning-based classification of hyperspectral data[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2014, 7(6): 2094-2107. DOI:10.1109/JSTARS.2014.2329330 |

| [14] |

CHEN Yushi, ZHAO Xing, JIA Xiuping. Spectral-spatial classification of hyperspectral data based on deep belief network[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2015, 8(6): 2381-2392. DOI:10.1109/JSTARS.2015.2388577 |

| [15] |

HU Wei, HUANG Yangyu, WEI Li, et al. Deep convolutional neural networks for hyperspectral image classification[J]. Journal of Sensors, 2015, 2015: 1-12. |

| [16] |

ZHU Lin, CHEN Yushi, GHAMISI P, et al. Generative adversarial networks for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(9): 5046-5063. DOI:10.1109/TGRS.2018.2805286 |

| [17] |

MOU Lichao, GHAMISI P, ZHU Xiao xiang. Deep recurrent neural networks for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(7): 3639-3655. DOI:10.1109/TGRS.2016.2636241 |

| [18] |

LI Wei, WU Guodong, ZHANG Fan, et al. Hyperspectral image classification using deep pixel-pair features[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(2): 844-853. DOI:10.1109/TGRS.2016.2616355 |

| [19] |

SINGHAL V, AGGARWAL H K, TARIYAL S, et al. Discriminative robust deep dictionary learning for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(9): 5274-5283. DOI:10.1109/TGRS.2017.2704590 |

| [20] |

MARIO H J, PAOLETTI M E, JAVIER P, et al. Active learning with convolutional neural networks for hyperspectral image classification using a new bayesian approach[J]. IEEE Transactions on Geoence and Remote Sensing, 2018(1): 1-22. |

| [21] |

JIAO Licheng, LIANG Miaomiao, CHEN Huan, et al. Deep fully convolutional network-based spatial distribution prediction for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(10): 5585-5599. DOI:10.1109/TGRS.2017.2710079 |

| [22] |

CHEN Yushi, JIANG Hanlu, LI Chunyang, et al. Deep feature extraction and classification of hyperspectral images based on convolutional neural networks[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(10): 6232-6251. DOI:10.1109/TGRS.2016.2584107 |

| [23] |

刘冰, 余旭初, 张鹏强, 等. 联合空-谱信息的高光谱影像深度三维卷积网络分类[J]. 测绘学报, 2019, 48(1): 53-63. LIU Bing, YU Xuchu, ZHANG Pengqiang, et al. Deep 3D convolutional network combined with spatial-spectral features for hyperspectral image classification[J]. Acta Geodaetica et Cartographica Sinica, 2019, 48(1): 53-63. DOI:10.11947/j.AGCS.2019.20170578 |

| [24] |

SCARSELLI F, GORI M, TSOI A C, et al. The graph neural network model[J]. IEEE Transactions on Neural Networks, 2009, 20(1): 61-80. DOI:10.1109/TNN.2008.2005605 |

| [25] |

SHUMAN D I, NARANG S K, FROSSARD P, et al. The emerging field of signal processing on graphs: extending high-dimensional data analysis to networks and other irregular domains[J]. IEEE Signal Processing Magazine, 2013, 30(3): 83-98. DOI:10.1109/MSP.2012.2235192 |

| [26] |

KIPF T N, WELLING M. Semi-supervised classification with graph convolutional networks[J]. International Conference on Learning Representations, 2017(1): 1-14. |

| [27] |

OJALA T, PIETIKAINEN M, MAENPAA T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(7): 971-987. DOI:10.1109/TPAMI.2002.1017623 |

| [28] |

GHAMISI P, PLAZA J, CHEN Yushi, et al. Advanced spectral classifiers for hyperspectral images: a review[J]. IEEE Geoscience and Remote Sensing Magazine, 2017, 5(1): 8-32. DOI:10.1109/MGRS.2016.2616418 |

| [29] |

WANG Liguo, HAO Siyuan, WANG Qunming, et al. Semi-supervised classification for hyperspectral imagery based on spatial-spectral label propagation[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 97: 123-137. DOI:10.1016/j.isprsjprs.2014.08.016 |

| [30] |

ZHAN Y, HU D, WANG Y, et al. Semisupervised hyperspectral image classification based on generative adversarial networks[J]. IEEE Geoence and Remote Sensing Letters, 2018, 15(2): 1-5. DOI:10.1109/LGRS.2017.2789315 |

| [31] |

LIU Bing, YU Xuchu, YU Anzhu, et al. Deep few-shot learning for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(4): 2290-2304. DOI:10.1109/TGRS.2018.2872830 |

| [32] |

TEBALDINI Stefano, YANG Xinwei, BAI Yu, et al. Progresses on SAR remote sensing of tropical forests: forest biomass retrieval and analysis of changing weather conditions[J]. Journal of Geodesy and Geoinformation Science, 2021, 4(1): 88-93. |

| [33] |

LIU Zhaoyan, TANG Lingli, LI Chuanrong, et al. T-S fuzzy remote sensing monitoring model of snail distribution by Landsat 8 and Sentinel 2 data[J]. Journal of Geodesy and Geoinformation Science, 2020, 3(4): 118-125. |