2. 深圳大学土木与交通工程学院, 广东 深圳 518060;

3. 深圳大学城市智慧交通与安全运维研究院, 广东 深圳 518060;

4. 深圳大学广东省城市空间信息工程重点实验室, 广东 深圳 518060;

5. 自然资源部大湾区地理环境监测重点实验室, 广东 深圳 518060

2. College of Civil and Transportation Engineering, Shenzhen University, Shenzhen 518060, China;

3. Institute of Urban Smart Transportation & Safety Maintenance, Shenzhen University, Shenzhen 518060, China;

4. Guangdong Key Laboratory of Urban Informatics, Shenzhen University, Shenzhen 518060, China;

5. MNR Key Laboratory for Geo-Environmental Monitoring of Great Bay Area, Shenzhen 518060, China

高精地图专为自动驾驶设计,是自动驾驶核心技术之一。它又被称为高分辨率地图,具有高精度的道路场景(车道线、交通标志、路沿等)、定位等信息,可以辅助自动驾驶过程中的感知、定位、路径规划、决策与控制,提高驾驶过程中的安全性。

近年来,针对高精地图的研究可以分为以下3个研究方向:高精地图格式[1-2]、高精地图数据结构和高精地图制作方法。由于本文主要讨论高精地图的数据结构和制作方法,因此,对高精地图格式不做详细介绍。从高精地图数据逻辑方面分析,文献[3]对高精地图的静态图层数据逻辑结构进行了分析,认为高精地图应该包括:道路层、车道网络层、车道线层与交通标志层。文献[4]提出了路径导航车道级地图体系结构。由于静态地图不能保证行驶的安全,文献[5]提出局部动态地图的概念,首次将动态物的感知纳入地图范畴。文献[6]提出不同驾驶级别的自动驾驶汽车需要依赖不同级别的高精地图;自动驾驶级别越高,对高精度地图的要求越高;指出L5级别自动驾驶汽车的需求为智能化的高精地图,即动态高精地图+分析数据的能力。

从高精地图制作方法分析,目前的高精地图制作均面向L3或L4级别的自动驾驶,未对L5级别的自动驾驶地图进行研究。面向L3或L4级别自动驾驶高精地图的构建可以分为数据采集、制图与地图更新3个步骤。其中,数据采集方案[7]均为通过搭配多种传感器的自动驾驶车辆或全景移动测量系统进行数据采集。但是无论自动驾驶数据采集车辆还是全景移动测量系统,成本均太过昂贵,不能实现大规模的数据采集,影响高精地图的制图和地图更新;同时,目前制图算法多基于深度学习来实现图像理解、定位等,该类算法存在数据需求量大、可解释性差等问题。

本文以智能化的高精地图为研究对象,提出多智能体协同高精地图构建定义与框架,并对其关键技术、构建过程中存在的挑战进行了分析,该框架的核心思想包括以下两点。

(1) 将数据采集平台由自动驾驶车辆或全景移动测量系统扩展为机器人、自动驾驶车辆、无人机等多种类型的智能体。通过搭配相同或者不同类型传感器的、不同类型的多个智能体协同采集数据,既降低了采集设备的成本,又保证了数据采集速度。

(2) 为保证高精地图的智能性、精度和地图更新速度,提出多智能协同高精地图的制作和更新框架。

本文的主要内容包括:①提出了多智能体协同高精地图构建定义和框架;②分析了多智能体协同高精地图构建过程中的关键技术;③研究了其构建过程中存在的挑战。

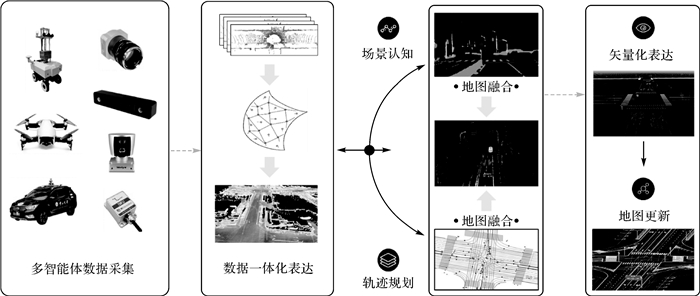

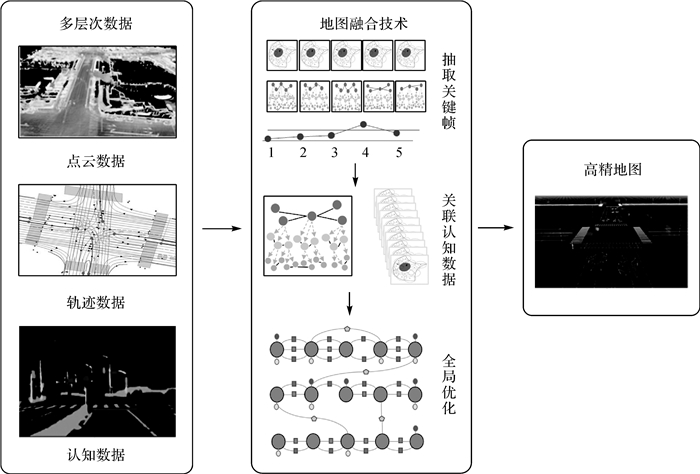

1 多智能体协同高精地图构建定义及框架多智能体协同高精地图构建指采用多个搭建相同或不同传感器(摄像机、激光雷达、GNSS、IMU等)、不同类型的智能体(自动驾驶车辆、机器人、无人机等)协同采集数据,并对数据进行处理,实现智能高精地图制作和更新的过程。依据多智能体协同高精地图构建定义,其具体构建框架如图 1所示。

|

| 图 1 多智能体协同高精地图构建 Fig. 1 Multi-agent collaborative high definition map construction |

(1) 多智能体数据采集:通过对多智能体进行路径规划,使其协同进行数据采集的过程。其中,如何令多智能体协同工作、规划多智能体数据采集路径,实现高效、高质量采集某区域的数据是该部分的重点和难点。

(2) 数据一体化表达:由于不同的传感器具有不同的数据表达形式(数据内容、格式、特性、精度等),为方便智能高精地图的制作,需要对多源异构数据进行一体化表达,得到三维地图。

(3) 场景认知:智能化的高精地图具有理解静态物、半静态物、半动态物和动态物的能力,还具有解释数据(认知)的能力。而目前基于深度学习的场景感知方法要求大量训练数据,且模型泛化能力差、不具有可解释性。因此,智能化的高精地图构建需要发展对数据量要求小、模型泛化能力强、具有可解释性的场景认知方法。

(4) 轨迹规划:轨迹规划用于表达虚拟道路和道路间的逻辑关系,并对自动驾驶车辆在各车道的可行驶轨迹进行规划,为自动驾驶车辆行驶过程中的导航提供强约束。

(5) 地图融合:基于认知数据和轨迹数据将不同空间、时间、层次的数据高精度地融合成为一个完整的高精地图。

(6) 矢量化表达:将形成的智能高精地图从俯视图角度进行矢量化表达,形成矢量地图,提供给自动驾驶车辆使用。

(7) 地图更新:自动驾驶程度越高,对高精度地图的准确度要求越高。而由于现实生活中频繁的道路建设和维修,使地图不能保持现势性,进而不能为自动驾驶车辆提供准确信息。因此,智能化的高精地图需要具有较好的更新能力。

2 多智能体协同高精地图构建关键技术 2.1 多智能体数据采集路径规划多智能体数据采集路径规划,即多个单智能体信息交互,在共同完成某个区域数据采集的过程中,每个智能体的路径规划;其本质为多智能体路径规划。针对多智能体路径规划问题,传统的方法一般采用遗传算法[8]和蚁群算法[9]求解。然而,随着问题规模的增大、计算复杂度增加,传统方法不能高效地规划多智能体路径。近年来,随着深度学习的发展,涌现出众多基于深度强化学习的路径规划方法[10],提高了规划的效率[11-12]。但是,现有的算法在进行多智能体路径规划时,通常将问题抽象为多旅行商问题[13-14],多旅行商问题不考虑场景的复杂性与动态性。而在多智能体数据采集时,场景的复杂性与动态性是影响数据采集效率和通信效率的重要因素之一,不可以被忽略。为解决此问题,本文建立适用于多智能体协同建图的路径规划模型。

集中学习和分散执行是一种多智能体协同策略。集中学习指通过应用集中的方法训练一组智能体,从而减轻智能体间通信负担。分散执行指智能体可以在其局部观测优势的基础上分散执行[15],这种体系在通信受限的情况对于保持多智能体间的信息高效交互意义重大[16]。文献[17]基于集中学习分散执行框架,提出了一种集中式专家监督多智能体强化学习算法,该算法采用DAgger算法获得单智能体分散执行策略,可以在较低的样本复杂度下训练分散执行多智能体策略。文献[18]将集中和分散的思想应用到主从多智能体架构中,主智能体处理来自从智能体的信息;从智能体接受主智能体消息,并结合自身信息来执行动作,显著降低了多智能体系统的通信负担。实际上,集中学习分散执行策略已成为多智能体系统协同的标准框架[19]。

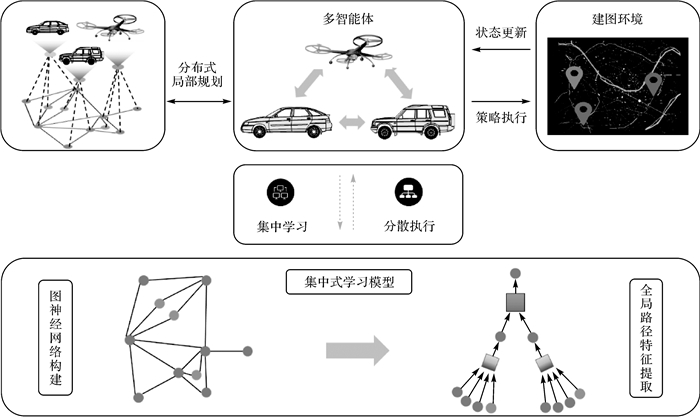

为了实现多智能体间信息交互与协同路径规划,本文提出采用“集中学习和分散执行”结合“多智能体强化学习”的多智能体协同路径规划模型,如图 2所示,以集中式深度学习模型学习多智能体全局路径规划,以分散式执行实现多智能体间高效信息交互,充分利用二者在信息处理与信息交互方面的优势。即:首先,基于深度强化学习算法分析单一智能体的观测和行为,学习建图环境状态更新信息;其次,通过深度神经网络,集中学习智能体之间的沟通和协同方法;最后,基于网络结构,实现智能体之间的交互及协同规划,从而完成基于集中学习分散处理的多智能体路径规划方案。

|

| 图 2 集中学习分散执行路径规划模型 Fig. 2 Path planning model with centralized learning and decentralized execution |

具体来讲,各智能体向集中式学习模型发送建图环境状态更新信息,如场景随时间动态变化、与预测复杂度差异较大等;集中式学习模型将全部更新信息集中表达为图神经网络的形式,并基于该网络同步更新全局实时地图特征。更新后的全局特征发送至所有智能体,为多智能体路径规划提供一个新的全局视野。多智能体接收来自集中学习模型提取的全局地图特征,结合局部观测信息进行分布式规划得到新的执行策略。

2.2 多源异构一体化数据融合与表达在多智能体协同地图构建中,基于不同采集平台得到的多源异构数据需要进行融合以构建地图。此过程中的难点为数据的异构性,即基于不同智能体及传感器得到的数据具有不同的内容、格式、特性及精度等。例如:激光雷达提供了测距范围与点反射值数据;相机提供了彩色或灰度图像数据;IMU提供了自身加速度、角速度等动量测量值;GNSS则提供了粗略的全局定位坐标。如何基于异构数据的不同特征描述数据关联,准确联合多时空数据,进行多源异构传感器数据时空域对齐;充分利用各异构传感器测量的优势并实现数据一体化表达,是完成多源异构数据融合、实现多智能体协同高精地图构建的重要基础。

高维学习的方法[20]可以提取高动态、剧烈变化环境下多源异构数据的特征,通过多源异构特征匹配能够在帧间实现多源异构数据的关联。同时,使用因子图[21]的方法,将概率图模型与图优化方法结合,能够将几何、语义和数据关联置于统一的框架中,进行环境建模和状态的估计。在地图的表示方法中,面元[22]在灵活性、表达能力占据了优势,能够支持多种传感器数据进行环境整合。因此,通过引入高维学习来进行异构数据的时空关联,并基于非高斯多假设估计器构建基于面元的多源异构一体化数据的表达模型,从而实现准确的多源异构一体化数据融合与表达,在理论上具备高可行性。

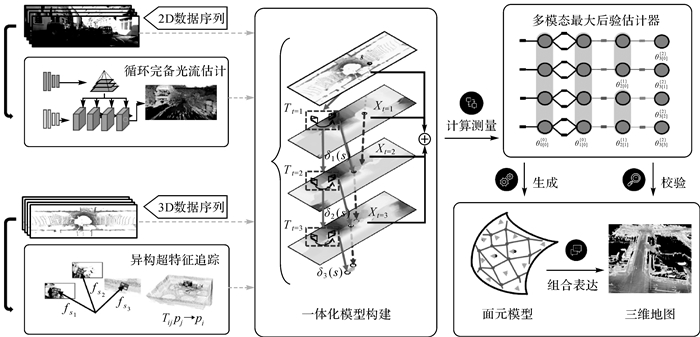

本文提出的多源异构一体化数据融合与表达主要分为3个部分:多源异构特征的选取,信息融合以及地图存储与表达。目前的工作大多使用高度近似的表达方式概括测量数据,尚缺乏多种异构数据紧耦合的方法。此外,现有的工作应用于数据分布未知的数据时,通常基于单高斯分布假设进行数据关联和残差构建,这类方法容易出现估计器状态不一致的问题,使得模型无法正常收敛。对于现有工作的不足,本文提出了4点改进的思路,如图 3所示。

|

| 图 3 多源异构一体化数据融合与表达 Fig. 3 Multi-source heterogeneous integration data fusion and expression |

(1) 通过引入高维学习的方法,改造前驱数据处理框架,进行多源异构数据的超特征追踪;选择场景表达最丰富的图像数据作为关键帧,利用立体深度图作为构造半稠密点云的先验。采用滑动窗口的形式,通过固定滞后平滑器优化窗口内深度状态量,提升半稠密点云精度。在激光雷达点云存在时,通过显著角点、深度连续三维线特征构建异构数据关联,为后端优化提供约束条件。

(2) 引入循环完备像素关联光流变换器,提升异构数据的时空关联性。针对未知深度的数据(例如:RGB图像),依据序列的连续性假设,通过估计其“密集位移场”,进行帧间特征数据关联。利用深度网络从输入的每一幅图像序列进行处理,得到特征编码;通过在所有序列的特征编码估计视觉相关性,构建图像金字塔;通过上下文网络和基于金字塔的辅助信息,计算图像序列帧间相关性。在密集高维特征图间,进行帧间的特征跟踪,最终得到光流计算结果。

(3) 研究非高斯多模态的最大后验估计器,考虑覆盖的数据不确定性范围。引入多假设非高斯因子图模型和“假设修剪”去除冗余假设,充分支持概率信息的分发与因子增量更新。同时考虑进行多假设贝叶斯树的推断,引入对观测的全贝叶斯推断,以确保参数得到最优的估计。

(4) 基于不确定性建模的面元构建表达模型,从而建立更准确的多源异构一体化数据表达模型,最终求解得到初始的环境模型及三维地图。对异构数据进行时空关联,并计算得到测量误差,根据误差和先验的传感器测量噪声模型构建残差因子,利用多假设非高斯因子图模型进行求解得到初始的环境模型。此外,利用形变图来进行面元调整,完成模型表面形变,细化环境模型。

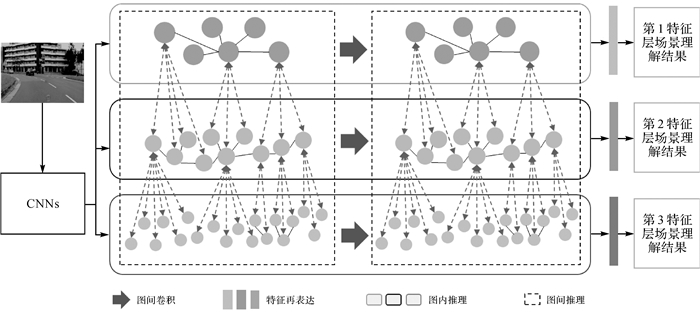

2.3 道路场景认知在传统的高精地图构建中通常实现对道路场景的理解,即对道路场景元素进行识别[23]、检测[24-26]、分割[27-28]和修复[29-30]。近年来,随着深度学习的发展,道路场景理解取得了显著的成果。但是,现有的道路场景理解多为对其进行感知理解。基于深度学习的感知理解需要大量的训练数据,并且训练后的模型泛化能力差,没有分析数据能力,无法服务智能化的高精地图。基于图推理的认知方法可以解决以上问题,目前基于图推理的认知仅在人体解析语义分割[31]、人体目标检测[32]和视觉语言任务[33]有少量的研究。但是该类研究的数据集简单,推理方法也相对简单。而道路场景认知任务的数据集里包含汽车、自行车、摩托车、标志、行人、路面等多个元素,且元素间关系复杂;认知结果面向无人驾驶车辆,认知精度要求高,因此,需要探索面向道路场景的认知方法。本文提出了基于图推理的道路场景认知方案,该方案分为了两个阶段:首先基于元素之间的相互关联特性构建道路场景异构图(图 4),然后基于图推理理论设计道路场景认知理解网络(图 5),实现对道路场景的认知。

|

| 图 4 道路场景理解异构图 Fig. 4 Road scene understanding heterogeneous graph |

|

| 图 5 基于图推理的道路场景认知理解网络 Fig. 5 Cognitive understanding network of road scene based on graph reasoning |

(1) 道路场景异构图构建。道路场景有汽车、行人、路面等多个元素组成。其中,部分元素可以依据特征进行细化,如汽车特征可以细化为车灯、车身、排气筒、车轮;车灯可以进一步细化为近光灯、前位灯、远光灯等。本文定义道路场景元素的特征为第1特征,第1特征构成的图层为第1特征层;第1次细分的特征为第2特征,第2特征构成的图层为第2特征层;第3特征和第3特征层的定义依据上述规则。特征层内依据元素间物理关系实现图内推理,相邻特征层间依据元素间物理关系实现图间推理。准确表达道路场景各特征层的图内推理和图间推理,即完成了道路场景异构图的构建。

(2) 基于图推理的道路场景认知理解网络。基于搭建的道路场景异构图,可以设计出道路场景理解网络。该网络以道路场景RGB图像为输入,首先,通过卷积神经网络(CNNs)提取图像特征;然后,通过图间卷积实现所有特征层的图内推理,并对其进行特征再表达,实现所有特征层的道路理解;最后,通过图间推理方法,实现图间特征理解,即完成了道路场景认知理解。

2.4 智能化的高精地图融合多智能体采集的地图数据包含了地图不同时间、空间、层次采集到的信息;同时,由于场景的变化,不同时空的信息之间可能发生变化,造成地图的不一致;各智能体采集到的数据也存在误差,需要经过地图融合来得到一致的高精地图。传统的地图融合方案在处理这些误差和不一致时,通常采用贝叶斯滤波[34]或手工较准等方法。但是,对于数据种类越来越多,数据规模越来越大的高精地图而言,传统的方案难以满足需求。因此,发展智能地图融合技术是未来高精地图构建中一项不可或缺的关键技术。为了解决此问题,本文从3个方面(图 6)进行了研究。

|

| 图 6 地图融合技术 Fig. 6 Map fusion technology |

(1) 基于认知抽取关键帧。智能化的高精地图数据量巨大,如何有效地滤除冗余数据,精简数据量的同时保证不损失地图的关键信息,对于城市规模量级的地图构建和融合具有重要意义。关键帧的抽取能够减少地图中的冗余信息,但传统的关键帧抽取方法[35]通常只考虑到局部的几何信息,没有考虑到全局的重复性和特殊性。而基于场景的认知,可以有效利用场景全局的信息。本文提出基于场景认知结构抽取关键帧,实现对数据的差异化度量,抽取关键帧,降低误差和冗余。

(2) 基于认知关联数据。由于多智能体协同建图的传感器种类多、精度参差不齐,在建图的过程中会由于传感器误差和建图误差降低高精地图的精度。回环检测已经被证明是一种有效的提升建图精度的方法[36],其利用场景中重复出现的部分,优化地图构建与融合。本文基于场景认知方法抽象出单帧数据中关键元素的关系[37],由此设计基于元素拓扑关系的回环检测框架,可进一步实现精细化数据关联,从而建立序列数据时空关联约束,降低地图误差,提升地图精度。

(3) 基于图优化理论对地图进行全局优化。三维地图的输出,需要对所有的约束信息进行集中优化计算,从而得到精准的环境模型[21]。本文基于图优化理论构建优化模型,提出将多类别、多层次的数据关联,放在统一的图优化框架中进行全局一致性整合与提升,从而实现平滑误差,提升地图精度。

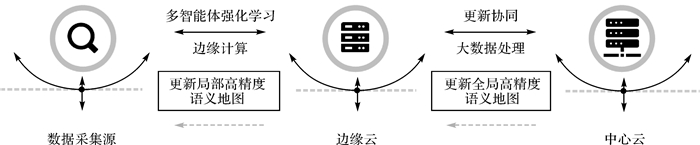

2.5 智能化的高精地图更新在自动驾驶领域,精度越高的地图意味着越高的安全性、可操作性。随着时代的高速发展,地图信息瞬息万变,因此,智能化的高精地图更新是一个重要问题。在传统的地图更新工作中,由于更新数据的数据量巨大、数据类型复杂,造成了云端响应时间长、网络拥堵等不良情况。对此,文献[6]提出了“众包+边云协同计算”模式来处理这个问题。此模式没有考虑智能体间的通信信息,且众包下部分智能体不受控,会造成智能体数据杂乱、冗余等问题,使得多智能体协同建图中的地图更新能力受限。针对多智能体通信问题,文献[38]提出了基于方差控制和多智能体强化学习的通信方法,证明了多智能体强化学习可以用于提高多智能体通信效率。本文提出基于边缘计算[39]和多智能体强化学习的高精地图更新方案(图 7)。

|

| 图 7 边缘计算+多智能体强化学习架构 Fig. 7 Edge computing+multi-agent reinforcement learning architecture |

如图 7所示,数据采集源包括自动驾驶汽车、无人机、机器人等设备,在进行数据一体化操作后,将更新数据提交给边缘云,边缘云在边缘计算技术的支持下进行多智能体强化学习,处理后向用户反馈局部高精地图。同时中心云在收到边缘云传来的海量数据后利用大数据技术进行处理,以协同各边缘云的更新工作,突出各边缘云需要的更新数据,处理完毕后向边缘云反馈全局高精地图。整个高精地图更新工作被分为了局部更新和全局更新两部分完成,理论上可以达到实时更新的效果。

具体来讲,中心云根据各边缘云所处环境不同,向不同的边缘云提出不同的地图更新需求,如更新的数据类型、上传的数据量等。边缘云根据需求对该范围内的多智能体进行多智能体强化学习,即中心化训练、去中心化执行。在多智能体执行过程中,智能体间通过通信[38],传递彼此状态信息,从而促进各智能体更好地协同,得到优化的更新数据。最终,通过多智能体强化学习方法区分出高更新频率的数据类型和非高更新频率的数据类型。如果是高更新频率的数据类型,则进行局部的高精地图更新;如果是非高更新频率的数据类型,则判断是否达到了中心云设定的周期,如果满足,则进行全局的高精地图更新。

3 存在的挑战本文提出了多智能体协同高精地图构建的框架,并对其关键技术进行了研究,但是在制图过程中,仍存在着以下挑战。

(1) 随着经济的快速发展,地图数据采集场景变化越来越快(车辆及行人流动性,建筑物改造等),而智能体的数据交互及处理能力有限,如何解决多智能体系统异步通信带来的延迟问题,保证系统一致性,是多智能体路径规划的一个主要挑战。

(2) 以特征间关系构建的道路场景异构图中,图内关系和图间关系错综复杂,如何建立准确有效的道路场景元素异构图,发展图内推理和图间推理方法,是实现道路场景认知的关键科学问题,也是目前亟待解决的重要挑战。

(3) 为保证地图的覆盖率及更新频率,需要采集大量的数据。在地图融合的过程中,如何有效地滤除冗余信息,同时保证不损失地图的关键信息,对于城市规模量级的地图构建工作是一个挑战。

4 总结为实现高效、高精度、智能化的地图构建,本文定义了一种多智能体协同地图构建方式,提出了其构建框架,对其关键技术进行了分析。具体包括集中学习分散执行路径规划模型、多源异构一体化数据融合与表达框架、基于推理的道路场景认知理解框架、智能化的地图融合技术框架、基于边缘计算和多智能体强化学习的地图更新框架,并对其在构建过程中可能存在的挑战进行了分析。

| [1] |

Navigation Data Standard. Publishing high-accuracy map standard for companies: industrial consortium pushes autonomous driving[EB/OL]. [2016-09-14]. https://www.Nds-association.org/wp-content/uploads/20160914-PR-E.pdf.

|

| [2] |

DUPUIS M, STROBL M, GREZLIKOWSKI H. OpenDRIVE 2010 and beyond-status and future of the de facto standard for the description of road networks[C]//Proceedings of 2010 Driving Simulation Conference Europe. Paris, France: [s. n. ], 2010: 231-242.

|

| [3] |

贺勇, 路昊, 王春香, 等. 基于多传感器的车道级高精细地图制作方法[J]. 长安大学学报(自然科学版), 2015, 35(S1): 274-278. HE Yong, LU Hao, WANG Chunxiang, et al. Generation of precise lane-level maps based on multi-sensors[J]. Journal of Chang'an University (Natural Science Edition), 2015, 35(S1): 274-278. |

| [4] |

LIU C, JIANG K, YANG D, et al. Design of a multi-layer lane-level map for vehicle route planning[C]//Proceedings of 2017 MATEC web of conferences. Les Ulis Cedex, France: EDP Sciences, 2017.

|

| [5] |

SHIMADA H, YAMAGUCHI A, TAKADA H, et al. Implementation and evaluation of local dynamic map in safety driving systems[J]. Journal of Transportation Technologies, 2015, 5(2): 102. DOI:10.4236/jtts.2015.52010 |

| [6] |

刘经南, 詹骄, 郭迟, 等. 智能高精地图数据逻辑结构与关键技术[J]. 测绘学报, 2019, 48(8): 939-953. LIU Jingnan, ZHAN Jiao, GUO Chi, et al. Data logic structure and key technologies on intelligent high-precision map[J]. Act Geodaetica et Cartographica Sinica, 2019, 48(8): 939-953. DOI:10.11947/j.AGCS.2019.20190125 |

| [7] |

李德仁. 移动测量技术及其应用[J]. 地理空间信息, 2006, 4(4): 1-5. LI Deren. Mobile mapping technology and its applications[J]. Geospatial Information, 2006, 4(4): 1-5. DOI:10.3969/j.issn.1672-4623.2006.04.001 |

| [8] |

AL-FURHUD M A, AHMED Z H. Genetic algorithms for the multiple travelling salesman problem[J]. International Journal of Advanced Computer Science and Applications (IJACSA), 2020, 11(7): 553-560. |

| [9] |

CUEVAS A M C, MARTINEZ J A S, SAUCEDO J A M. A two stage method for the multiple traveling salesman problem[J]. International Journal of Applied Metaheuristic Computing (IJAMC), 2020, 11(3): 79-91. DOI:10.4018/IJAMC.2020070104 |

| [10] |

万里鹏, 兰旭光, 张翰博, 等. 深度强化学习理论及其应用综述[J]. 模式识别与人工智能, 2019, 32(1): 67-81. WAN Lipeng, LAN Xuguang, ZHANG Hanbo, et al. A review of deep reinforcement learning theory and application[J]. Pattern Recognition and Artificial Intelligence, 2019, 32(1): 67-81. |

| [11] |

HU Y, YAO Y, LEE W S. A reinforcement learning approach for optimizing multiple traveling salesman problems over graphs[J]. Knowledge-Based Systems, 2020, 204: 106244. DOI:10.1016/j.knosys.2020.106244 |

| [12] |

CARION N, USUNIER N, SYNNAEVE G, et al. A structured prediction approach for generalization in cooperative multi-agent reinforcement learning[J]. Advances in neural information processing systems, 2019, 32: 8130-8140. |

| [13] |

ZANGINA U, BUYAMIN S, AMAN M N, et al. Autonomous mobility of a fleet of vehicles for precision pesticide application[J]. Computers and Electronics in Agriculture, 2021, 186: 106217. DOI:10.1016/j.compag.2021.106217 |

| [14] |

LUO Z, POON M, ZHANG Z, et al. The multi-visit traveling salesman problem with multi-drones[J]. Transportation Research Part C: Emerging Technologies, 2021, 128: 103172. DOI:10.1016/j.trc.2021.103172 |

| [15] |

KRAEMER L, BANERJEE B. Multi-agent reinforcement learning as a rehearsal for decentralized planning[J]. Neurocomputing, 2016, 190: 82-94. DOI:10.1016/j.neucom.2016.01.031 |

| [16] |

ALLEN M W, HAHN D, MACFARLAND D C. Heuristics for multiagent reinforcement learning in decentralized decision problems[C]//Proceedings of 2014 IEEE Symposium on Adaptive Dynamic Programming and Reinforcement Learning (ADPRL). Orlando, FL, USA: IEEE, 2014: 1-8.

|

| [17] |

LIN T, DEBORD M J, ESTABRIDIS K, et al. Decentralized multi-agents by imitation of a centralized controller[C]//Proceedings of 2019 International Conference on Robotics and Automation (ICRA). Montreal, Canada: IEEE, 2019: 7990-7996.

|

| [18] |

KONG X, XIN B, Wang Y, et al. Collaborative deep reinforcement learning for joint object search[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Hawaii, USA: IEEE, 2017: 1695-1704.

|

| [19] |

NGUYEN T T, NGUYEN N D, NAHAVANDI S. Deep reinforcement learning for multiagent systems: a review of challenges, solutions, and applications[J]. IEEE transactions on cybernetics, 2020, 50(9): 3826-3839. DOI:10.1109/TCYB.2020.2977374 |

| [20] |

BOROSON, ELIZABETH R, NORA A. 3D keypoint repeatability for heterogeneous multi-robot SLAM[C]//Proceedings of 2019 International Conference on Robotics and Automation (ICRA). Montreal, Canada: IEEE, 2019: 6337-6343.

|

| [21] |

CADENA C, CARLONE L, CARRILLO H, et al. Past, present, and future of simultaneous localization and mapping: toward the robust-perception age[J]. IEEE Transactions on robotics, 2016, 32(6): 1309-1332. DOI:10.1109/TRO.2016.2624754 |

| [22] |

WANG K, GAO F, SHEN S. Real-time scalable dense surfel mapping[C]//Proceedings of 2019 International Conference on Robotics and Automation (ICRA). Montreal, Canada: IEEE, 2019: 6919-6925.

|

| [23] |

CHEN L, ZHAN W, TIAN W, et al. Deep integration: a multi-label architecture for road scene recognition[J]. IEEE Transactions on Image Processing, 2019, 28(10): 4883-4898. DOI:10.1109/TIP.2019.2913079 |

| [24] |

CHEN J, LEI B, SONG Q, et al. A hierarchical graph network for 3D object detection on point clouds[C]//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, WDC: IEEE, 2020: 392-401.

|

| [25] |

陈世增, 李必军, 周继苗. 利用双灭点估计的车道线检测[J]. 测绘通报, 2020(1): 16-20. CHEN Shizeng, LI Bijun, ZHOU Jimiao. Lane detection with double vanishing points estimation[J]. Bulletin of Surveying and Mapping, 2020(1): 16-20. |

| [26] |

LONG S U N, TAO W U, GUANGCAI S U N, et al. Object detection research of SAR image using improved faster region-based convolutional neural network[J]. Journal of Geodesy and Geoinformation Science, 2020, 3(3): 18-28. |

| [27] |

ZHONG Z, LIN Z Q, BIDART R, et al. Squeeze-and-attention networks for semantic segmentation[C]//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, WDC, USA: IEEE, 2020: 13065-13074.

|

| [28] |

ZHOU D, FANG J, SONG X, et al. Joint 3D instance segmentation and object detection for autonomous driving[C]//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, WDC, USA: IEEE, 2020: 1839-1849.

|

| [29] |

ZHAO L, MO Q, LIN S, et al. UCTGAN: Diverse image inpainting based on unsupervised cross-space translation[C]//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, WDC, USA: IEEE, 2020: 5741-5750.

|

| [30] |

HUANG Z, YU Y, XU J, et al. PF-Net: Point fractal network for 3D point cloud completion[C]//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, WDC, USA: IEEE, 2020: 7662-7670.

|

| [31] |

GONG K, GAO Y, LIANG X, et al. Graphonomy: Universal human parsing via graph transfer learning[C]//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. California, USA: IEEE, 2019: 7450-7459.

|

| [32] |

XU H, FANG L, LIANG X, et al. Universal-rcnn: universal object detector via transferable graph r-cnn[C]//Proceedings of 2020 AAAI Conference on Artificial Intelligence. New York, USA: AAAI, 2020, 34(7): 12492-12499.

|

| [33] |

YU W, ZHOU J, YU W, et al. Heterogeneous graph learning for visual commonsense reasoning[J]. Advances in Neural Information Processing Systems, 2019(32): 2769-2779. |

| [34] |

MCCORMAC J, HANDA A, DAVISON A, et al. Semantic fusion: dense 3D semantic mapping with convolutional neural networks[C]//Proceedings of 2017 IEEE International Conference on Robotics and automation (ICRA). Singapore: IEEE, 2017: 4628-4635.

|

| [35] |

CAMPOS C, ELVIRA R, RODRÍGUEZ J J G, et al. ORB-SLAM3: an accurate open-source library for visual, visual-inertial, and multimap SLAM[J]. IEEE Transactions on Robotics, 2021, 42(9): 1-17. |

| [36] |

GAO X, WANG R, DEMMEL N, et al. LDSO: direct sparse odometry with loop closure[C]//Proceedings of 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Madrid, Spain: IEEE, 2018: 2198-2204.

|

| [37] |

ATANASOV N, BOWMAN S L, DANIILIDIS K, et al. A unifying view of geometry, semantics, and data association in SLAM[C]//Proceedings of 2018 International Joint Conference on Artificial Intelligence (IJCAI). Stockholm, Sweden: IJCAI, 2018: 5204-5208.

|

| [38] |

ZHANG S Q, ZHANG Q, LIN J. Efficient communication in multi-agent reinforcement learning via variance based control[C]//Proceedings of 2019 International Conference on Neural Information Processing Systems. Vancouver, Canada: MIT, 2019: 3235-3244.

|

| [39] |

LI H, OTA K, DONG M. Learning IoT in edge: deep learning for the internet of things with edge computing[J]. IEEE network, 2018, 32(1): 96-101. DOI:10.1109/MNET.2018.1700202 |